Le carte di Huawei per la partita dell'AI mondiale

All'evento Huawei Connect 2025 la casa cinese ha messo in fila le sue innovazioni per guidare il mercato delle piattaforme tecnologiche per l'AI

Per adesso, e probabilmente ancora per un bel po', lo sviluppo in campo IT non può essere scollegato più di tanto dalle questioni geopolitiche: c'è chi ha facile accesso a determinate componenti tecnologiche e chi, invece, no. Tra le aziende che "no", quelle cinesi sono in prima fila. E questo si scontra sia con le loro ambizioni, sia con quelle di Pechino. Che sulla prevalenza tecnologica punta come base anche per una prevalenza geopolitica.

Intendiamoci, le aziende tecnologiche cinesi hanno ampiamente dimostrato di poter fare a meno di molta della tecnologia occidentale. Basta svilupparne altra in casa propria e, quando necessario, supplire ai gap nella componentistica con una buona dose di inventiva architetturale. Gli esempi non mancano, ma in questa fase è soprattutto Huawei che punta su questo modello di sviluppo per giocare un ruolo chiave nella partita globale dell'AI. Quantomeno, questo è il messaggio che si è tratto dall'evento Huawei Connect 2025 di Shangai.

Un messaggio che, in parte, Eric Xu, Rotating Chair di Huawei, aveva già dato lo scorso anno: non si fa AI senza potenza di calcolo, questa deriva da chip di nuova generazione, in quanto a chip la Cina ha un gap con l'Occidente che permarrà per qualche tempo, l'ostacolo si può aggirare sviluppando chip magari meno potenti ma sfruttati con architetture di calcolo innovative. Resta questa, ancora oggi, la strada che Huawei ha deciso di seguire e che, quest'anno, si è concretizzata con diversi annunci importanti a tutti i livelli: chip, sistemi, tecnologie di base.

Dai processori in su

Per quanto riguarda i processori per l'AI - la famiglia di chip Ascend - Huawei ha definito una roadmap con rilasci a cadenza annuale, con ogni nuova serie di chip che offre più potenza di calcolo rispetto alla precedente. Tra inizio e fine 2026 arriveranno due modelli della serie 950, uno ottimizzato per la fase di "prefill" negli algoritmi generativi e per i motori di raccomandazione, l'altro per le funzioni di decodifica inferenziale e l'addestramento dei modelli. A fine 2027 è attesa la serie 960, con il doppio della potenza di calcolo, e un anno dopo la 970, che punta a un ulteriore raddoppio delle performance.

"I chip Ascend - ha spiegato Eric Xu - sono le basi per lo sviluppo di soluzioni IT che soddisfino le esigenze dei nostri clienti". A livello di sistemi, questo rimanda soprattutto ai SuperPoD. Un SuperPoD è un insieme di nodi fisici - server e rack, in pratica - che operano come un sistema logico unico. Anche grazie al lavoro che Huawei ha portato avanti nelle tecnologie di interconnessione, che per i sistemi in cluster ad alta densità devono garantire banda elevata, stabilità dei collegamenti, bassa latenza.

Per questo Huawei ha sviluppato un'architettura di interconnessione ottica con portata di oltre 200 metri, larghezza di banda nell'ordine del Terabit al secondo e latenza di 2,1 microsecondi, in grado di fare failover di blocchi delle connessioni anche solo di 100 nanosecondi. Tutto questo è stato "impacchettato" in un protocollo di interconnessione - ufficialmente UnifiedBus, Lingqu in casa Huawei - che è stato ora rilasciato come protocollo aperto, implementabile anche da terze parti e per i più generici cluster di supercomputing.

Le nuove evoluzioni tecnologiche di Huawei supporteranno in primis l'Atlas 950 SuperPoD, atteso per fine 2026, e poi l'Atlas 960 SuperPoD, a fine 2027. Il primo è un sistema da 160 rack e 8.192 chip 950, con potenza di calcolo AI sino a 16 Exaflop. "Supererà di gran lunga le sue controparti", ha sottolineato Xu, evidenziando in particolare che l'Atlas 950 fornirà una potenza di calcolo pari a quasi 7 volte quella dell'atteso sistema NVL144 di Nvidia. L'Atlas 960 SuperPoD è invece un sistema da 220 rack e 15.488 chip 960 che avrà, secondo le stime Huawei, il quadruplo della potenza di calcolo AI dell'Atlas 950.

A chi non bastasse tutta questa potenza dei futuri sistemi SuperPod, Huawei propone le loro configurazioni in cluster, che saranno lanciate contestualmente. L'Atlas 950 SuperCluster sarà composto da 64 Atlas 950 SuperPoD connessi in UBoE (UB over Ethernet) e punta a fornire 524 Exaflop di potenza AI ("supererà persino il Colossus di xAI, ora il più grande cluster di calcolo del mondo", ha sottolineato Xu). Analogamente, alla fine del 2027 debutterà l'Atlas 960 SuperCluster, un sistema con oltre un milione di chip 960 che punta a una potenza di calcolo massima, per l'AI, di ben 4 Zettaflop.

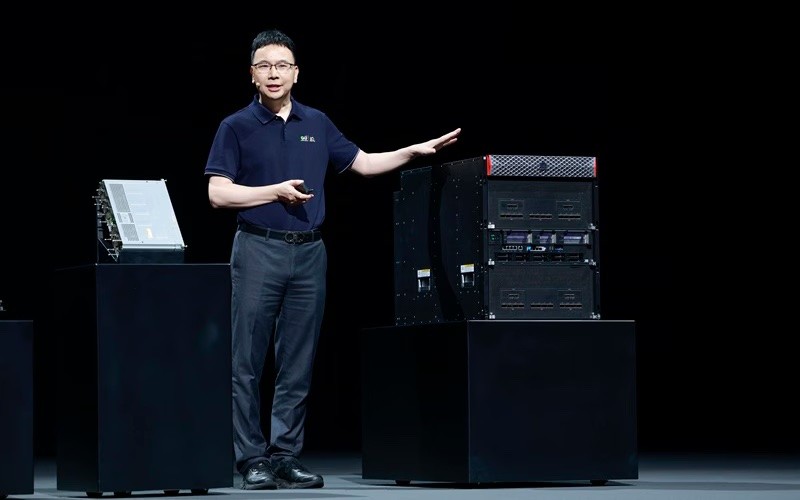

Yang Chaobin, CEO dell'ICT Business Group di Huawei, e l'Atlas 850 SuperPoD

Yang Chaobin, CEO dell'ICT Business Group di Huawei, e l'Atlas 850 SuperPoD

In realtà Huawei spinge i sistemi SuperPod anche in configurazioni meno estreme e più adatte alle imprese che fanno AI sì, ma come utenti "normali". Segue questa logica l'Atlas 850 SuperPoD, che parte da solo 8 chip Ascend e volendo scala sino a configurazioni da 128 unità e con 1.024 chip.

Non solo AI

I SuperPod sono proposti anche per l'IT "generica", quella cioè non strettamente legata all'addestramento degli algoritmi di AI e all'inferenza. L'obiettivo è in particolare spingerli come soluzioni di nuova concezione per gli ambiti che hanno requisiti di prestazioni e affidabilità più elevati rispetto ai normali cluster di server.

I SuperPoD "generici" puntano non sui processori Ascend ma sulle più tradizionali CPU Huawei in tecnologia ARM. Parliamo dei processori Kunpeng e in particolare del Kunpeng 950, del quale arriveranno, a inizio 2026, due versioni da 96 e 192 core e poi, a inizio 2028, altre versioni più potenti da 96 e 256 core. Ad adottare subito le nuove CPU sarà il sistema TaiShan 950 SuperPoD, disponibile da inizio 2026 con configurazioni fino a 16 nodi, 48 TB di memoria e 32 processori. Sarà - nelle parole di Xu - una "valida alternativa ai mainframe e ai sistemi midrange, e persino ai database server Exadata di Oracle".

Huawei ha deciso di portare sul mercato anche sistemi SuperPoD "ibridi" che combinano i TaiShan 950 con gli Atlas 950, ossia nodi ottimizzati per l'AI e nodi per l'IT generica, con in comune pool di memoria di dimensioni anche molto elevate. L'idea di fondo di questa architettura è che i nodi tradizionali gestiscano e organizzino petabyte e petabyte di dati "grezzi" di base, da passare poi ai nodi di AI per le funzioni di analisi basate sugli algoritmi di Intelligenza Artificiale. Il meglio, insomma, dei due mondi.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

f.p.

f.p.