AWS Re:Invent 2020: verso il nuovo computing

Dai container al serverless computing passando per i processori verticali: il computing cambia e AWS vuole guidare questo sviluppo

Il messaggio che Andy Jassy, CEO di AWS, ha voluto dare al lancio del Re:Invent 2020 è stato abbastanza chiaro. AWS non intende essere solo un fornitore di servizi e soluzioni cloud e hybrid cloud ma anche innovare - e reinventare, per restare fedele al claim dell'evento - gli ambiti tecnologici su cui il cloud si basa. Si parte dalla base più importante: il computing. Che per Jassy è tutt'altro che un ambito consolidato: "Il computing continua ad essere reinventato", partendo da quella trasformazione che è la base del cloud: non più server fisici ma istanze virtualizzate, poi container e serverless computing.

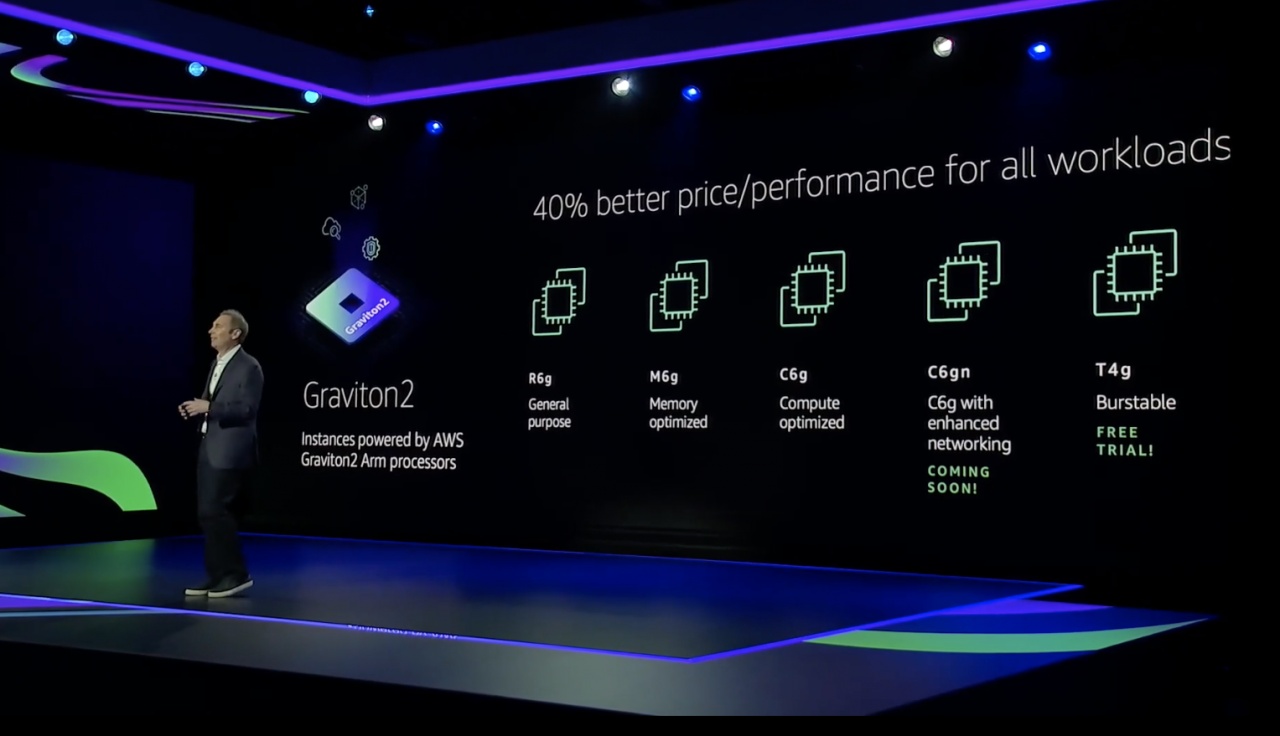

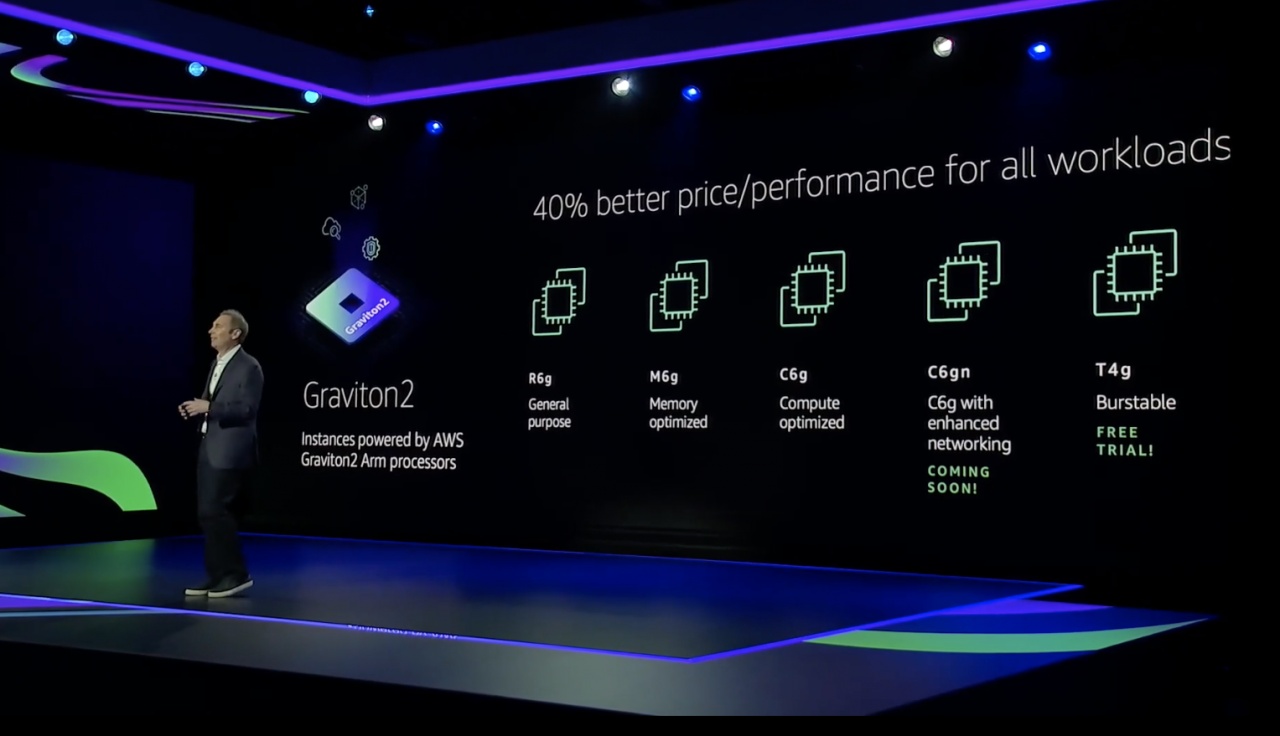

Accanto a questa evoluzione se ne muove un'altra che è legata ad un nuovo modo di vedere i processori. Anche AWS di fatto sottolinea come non sia più possibile aspettare le innovazioni dei classici produttori di chip e i passi avanti della Legge di Moore. Lo sviluppo di processori ed acceleratori mirati è un dato di fatto. Spicca semmai che non si tratti più di una questione da tecnici, che resta nel back-end dei data center. Jassy la porta sul palco per spiegare come il lavoro fatto su chip specifici si traduca in benefici per chi poi usa i servizi cloud.

Gli ambiti possibili per i chip di casa AWS sono molti. Il primo Graviton, processore disegnato su architettura ARM, ha avuto un successo per così dire di mercato, nel senso che le istanze di computing basate su di esso sono state molto richieste dagli utenti. Ora AWS rilancia con Graviton2, che offre livelli di performance dichiarati superiori del 40%. "Siamo ben lontani dall'aver finito di innovare con Graviton", sottolinea Jassy.

Un lavoro che conta anche nel campo del machine learning. Dove trovano sempre più spazio i processori di AWS. Inferentia per la parte di calcolo inferenziale era già noto, ora è il momento del lancio del secondo chip custom per il ML. È Trainium, progettato per la parte di addestramento degli algoritmi e basato sullo stesso SDK (Neuron) di Inferentia. Il rapporto con Intel in campo AI resta comunque forte: insieme a Trainium sono annunciate nuove istanze, dedicate all'addestramento dei modelli di machine learning, basate sull'architettura Habana Gaudi.

Un lavoro che conta anche nel campo del machine learning. Dove trovano sempre più spazio i processori di AWS. Inferentia per la parte di calcolo inferenziale era già noto, ora è il momento del lancio del secondo chip custom per il ML. È Trainium, progettato per la parte di addestramento degli algoritmi e basato sullo stesso SDK (Neuron) di Inferentia. Il rapporto con Intel in campo AI resta comunque forte: insieme a Trainium sono annunciate nuove istanze, dedicate all'addestramento dei modelli di machine learning, basate sull'architettura Habana Gaudi.

In quanto computing in cloud, sottolinea in sostanza Jassy, c'è ormai ampia scelta di istanze. Da quelle generaliste a quelle più mirate. Da quelle più semplici a quelle più "carrozzate" di core e storage. Ampiezza di scelta che permette alle aziende di sviluppare nuovi processi, prodotti o servizi rapidamente e con elasticità. Il futuro però è decisamente orientato verso la "leggerezza" dei container e la semplicità (lato utente) del serverless computing.

A questo servono i nuovi Amazon ECS Anywhere ed Amazon EKS Anywhere. In sostanza permettono di creare ambienti a container on-premise usando le stesse tecnologie di quelli ospitati nel cloud AWS. E per questo perfettamente integrabili con esso. La differenza fra i due moduli è quella che c'è già tra ECS ed EKS in cloud: l'Elastic Kubernetes Service è esplicitamente basato su Kubernetes, o meglio sulla distribuzione di Kubernetes sviluppata da AWS.

ECS ed EKS comunque possono appoggiarsi entrambi su AWS Fargate per gestire i container in logica serverless computing, quindi senza che ci si debba occupare di gestire, configurare e monitorare i cluster collegati ai container. In senso opposto, ora è anche possibile implementare funzioni Lambda come container. Una opzione che avvicina al serverless (e soprattutto event-driven) computing anche le aziende che hanno investito molto sulle tecnologie e i tool da container.

ECS ed EKS comunque possono appoggiarsi entrambi su AWS Fargate per gestire i container in logica serverless computing, quindi senza che ci si debba occupare di gestire, configurare e monitorare i cluster collegati ai container. In senso opposto, ora è anche possibile implementare funzioni Lambda come container. Una opzione che avvicina al serverless (e soprattutto event-driven) computing anche le aziende che hanno investito molto sulle tecnologie e i tool da container.

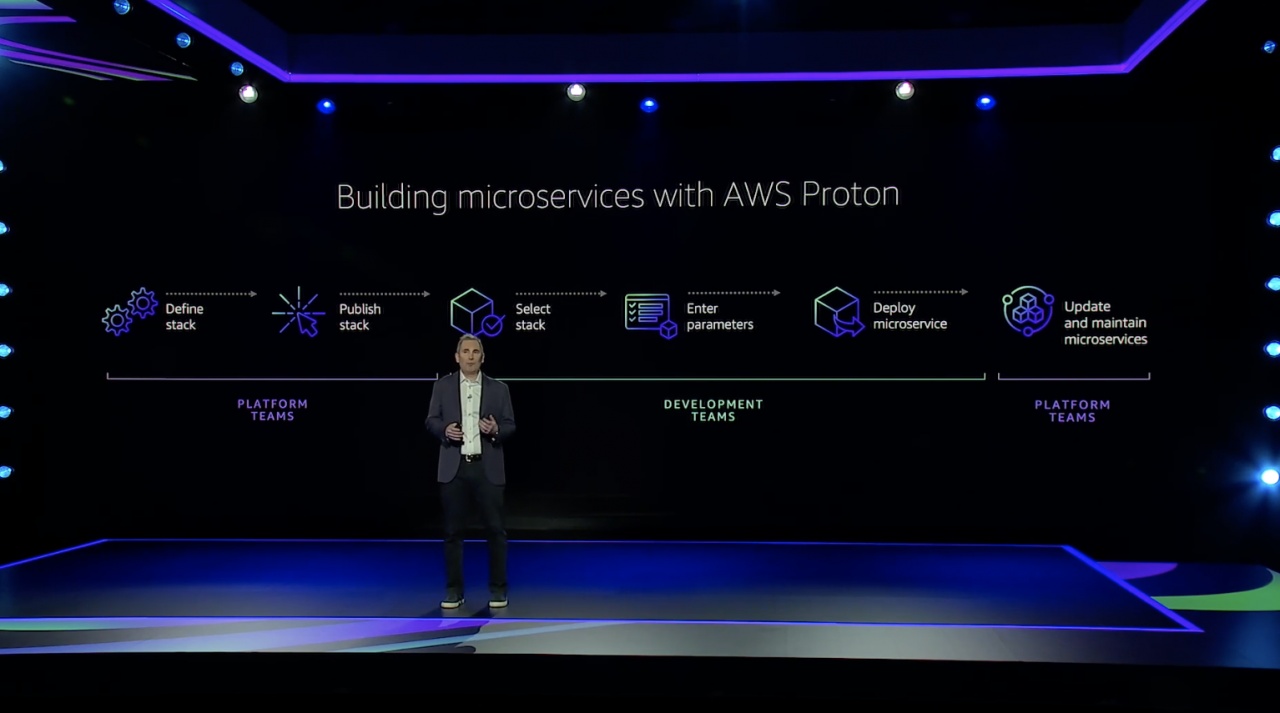

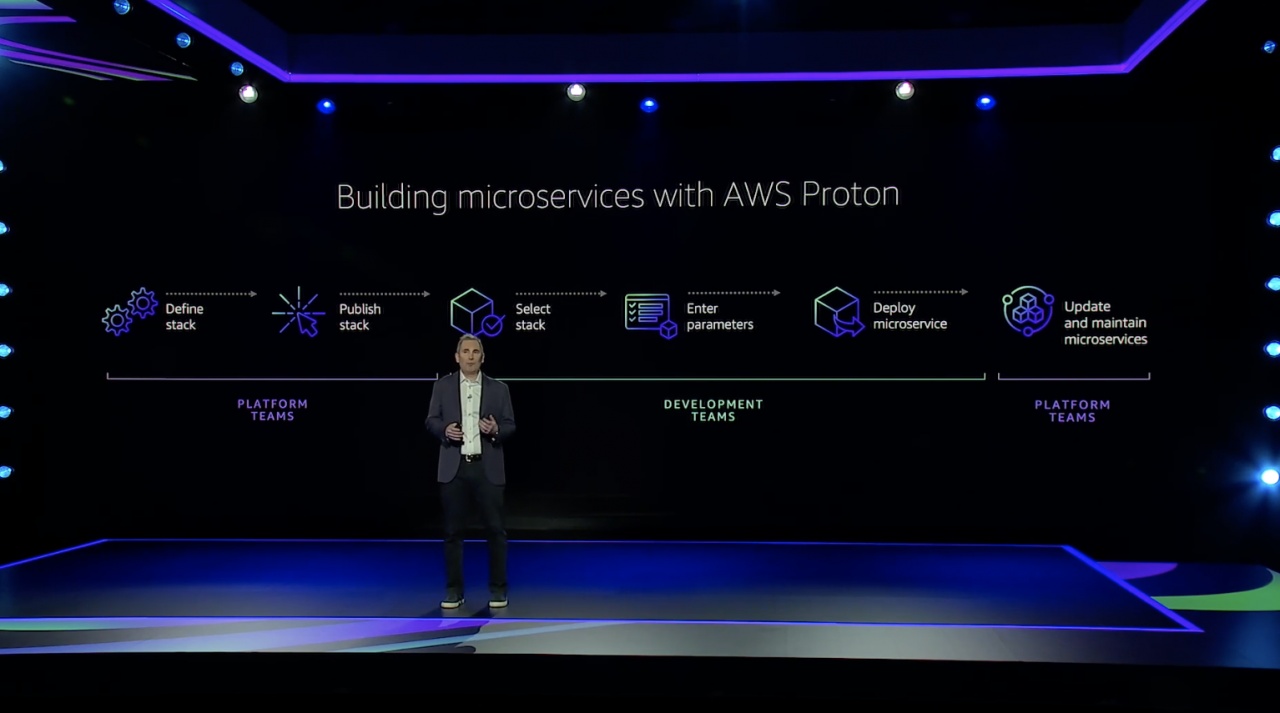

Cosa manca ancora in questo scenario? Secondo AWS, una piattaforma che porti al mondo container/serverless le funzioni di orchestrazione e gestione dello sviluppo, come i tool CI/CD fanno per lo sviluppo tradizionale. "I microservizi sono sempre più popolari ma è difficile passare a unità di elaborazione sempre più piccole e che devono operare in maniera coordinata. Che hanno tool e pipeline diverse, ma anche team di sviluppo diversi... È difficile coordinare tutto questo, non c'è qualcosa che aiuti i clienti in modo pervasivo", spiega Andy Jassy.

La risposta è AWS Proton, in sintesi estrema una piattaforma cloud per la progettazione e l'implementazione di microservizi. Nell'ottica di Proton il mattoncino base dei microservizi è uno "stack", che definisce tutto ciò che serve a supportare un microservizio. Quindi risorse di elaborazione, networking, pipeline del codice, sicurezza, monitoring. In questo modo esiste una piattaforma centralizzata che associa una volta per tutte un microservizio alle sue risorse, evitando problemi di configurazione. E così anche conflitti tra i team di sviluppo e quelli di operations.

Accanto a questa evoluzione se ne muove un'altra che è legata ad un nuovo modo di vedere i processori. Anche AWS di fatto sottolinea come non sia più possibile aspettare le innovazioni dei classici produttori di chip e i passi avanti della Legge di Moore. Lo sviluppo di processori ed acceleratori mirati è un dato di fatto. Spicca semmai che non si tratti più di una questione da tecnici, che resta nel back-end dei data center. Jassy la porta sul palco per spiegare come il lavoro fatto su chip specifici si traduca in benefici per chi poi usa i servizi cloud.

Gli ambiti possibili per i chip di casa AWS sono molti. Il primo Graviton, processore disegnato su architettura ARM, ha avuto un successo per così dire di mercato, nel senso che le istanze di computing basate su di esso sono state molto richieste dagli utenti. Ora AWS rilancia con Graviton2, che offre livelli di performance dichiarati superiori del 40%. "Siamo ben lontani dall'aver finito di innovare con Graviton", sottolinea Jassy.

Un lavoro che conta anche nel campo del machine learning. Dove trovano sempre più spazio i processori di AWS. Inferentia per la parte di calcolo inferenziale era già noto, ora è il momento del lancio del secondo chip custom per il ML. È Trainium, progettato per la parte di addestramento degli algoritmi e basato sullo stesso SDK (Neuron) di Inferentia. Il rapporto con Intel in campo AI resta comunque forte: insieme a Trainium sono annunciate nuove istanze, dedicate all'addestramento dei modelli di machine learning, basate sull'architettura Habana Gaudi.

Un lavoro che conta anche nel campo del machine learning. Dove trovano sempre più spazio i processori di AWS. Inferentia per la parte di calcolo inferenziale era già noto, ora è il momento del lancio del secondo chip custom per il ML. È Trainium, progettato per la parte di addestramento degli algoritmi e basato sullo stesso SDK (Neuron) di Inferentia. Il rapporto con Intel in campo AI resta comunque forte: insieme a Trainium sono annunciate nuove istanze, dedicate all'addestramento dei modelli di machine learning, basate sull'architettura Habana Gaudi.In quanto computing in cloud, sottolinea in sostanza Jassy, c'è ormai ampia scelta di istanze. Da quelle generaliste a quelle più mirate. Da quelle più semplici a quelle più "carrozzate" di core e storage. Ampiezza di scelta che permette alle aziende di sviluppare nuovi processi, prodotti o servizi rapidamente e con elasticità. Il futuro però è decisamente orientato verso la "leggerezza" dei container e la semplicità (lato utente) del serverless computing.

Difficoltà di gestione

L'ostacolo in questo senso è che molte aziende percepiscono tanto i vantaggi di container e funzioni as-a-Service ("il 50% delle nuove applicazioni in cloud usa AWS Lambda", sottolinea Jassy) quanto la complessità di gestire la modernizzazione delle applicazioni e la transizione dei container al cloud. Anche in questo caso la risposta di AWS è uniformare: dare la possibilità di gestire ambienti container e serverless on-premise e in cloud con le stesse funzioni di gestione.A questo servono i nuovi Amazon ECS Anywhere ed Amazon EKS Anywhere. In sostanza permettono di creare ambienti a container on-premise usando le stesse tecnologie di quelli ospitati nel cloud AWS. E per questo perfettamente integrabili con esso. La differenza fra i due moduli è quella che c'è già tra ECS ed EKS in cloud: l'Elastic Kubernetes Service è esplicitamente basato su Kubernetes, o meglio sulla distribuzione di Kubernetes sviluppata da AWS.

ECS ed EKS comunque possono appoggiarsi entrambi su AWS Fargate per gestire i container in logica serverless computing, quindi senza che ci si debba occupare di gestire, configurare e monitorare i cluster collegati ai container. In senso opposto, ora è anche possibile implementare funzioni Lambda come container. Una opzione che avvicina al serverless (e soprattutto event-driven) computing anche le aziende che hanno investito molto sulle tecnologie e i tool da container.

ECS ed EKS comunque possono appoggiarsi entrambi su AWS Fargate per gestire i container in logica serverless computing, quindi senza che ci si debba occupare di gestire, configurare e monitorare i cluster collegati ai container. In senso opposto, ora è anche possibile implementare funzioni Lambda come container. Una opzione che avvicina al serverless (e soprattutto event-driven) computing anche le aziende che hanno investito molto sulle tecnologie e i tool da container.Cosa manca ancora in questo scenario? Secondo AWS, una piattaforma che porti al mondo container/serverless le funzioni di orchestrazione e gestione dello sviluppo, come i tool CI/CD fanno per lo sviluppo tradizionale. "I microservizi sono sempre più popolari ma è difficile passare a unità di elaborazione sempre più piccole e che devono operare in maniera coordinata. Che hanno tool e pipeline diverse, ma anche team di sviluppo diversi... È difficile coordinare tutto questo, non c'è qualcosa che aiuti i clienti in modo pervasivo", spiega Andy Jassy.

La risposta è AWS Proton, in sintesi estrema una piattaforma cloud per la progettazione e l'implementazione di microservizi. Nell'ottica di Proton il mattoncino base dei microservizi è uno "stack", che definisce tutto ciò che serve a supportare un microservizio. Quindi risorse di elaborazione, networking, pipeline del codice, sicurezza, monitoring. In questo modo esiste una piattaforma centralizzata che associa una volta per tutte un microservizio alle sue risorse, evitando problemi di configurazione. E così anche conflitti tra i team di sviluppo e quelli di operations.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Abbonati alla rivista ImpresaCity Magazine e ricevi la tua copia.

f.p.

f.p.