Dell accelera su HPC e Quantum Computing

High Performance Computing e Quantum Computing possono essere democratizzati, secondo Dell, puntando sull'as-a-Service per l'HPC e sul Quantum Computing ibrido

Ci sono diversi punti di vista riguardo l'evoluzione tecnologica che le architetture IT aziendali seguiranno nel prossimo futuro. Ci sono però anche diversi punti fermi, tra cui certamente la constatazione che le imprese avranno sempre più necessità di elaborare grandi quantità di dati. È soprattutto per questo che High Performance Computing e Quantum Computing, due ambiti tecnologici una volta di interesse concreto solo in settori particolari - o addirittura nascenti, nel caso dell'elaborazione quantistica - oggi sono opzioni considerate da molte aziende.

Il problema è che HPC e Quantum Computing non si possono banalizzare. Implementare e utilizzare le loro tecnologie richiede gradi diversi, ma comunque mai riduttivi, di competenze e risorse. Perciò, lo sforzo che molti vendor tecnologici ora stanno facendo è quello di semplificare le tecnologie coinvolte e, ove possibile, proporle in forme quasi "a pacchetto" e anche a consumo.

In questo senso vanno letti gli annunci più recenti di Dell Technologies riguardo il mondo HPC e quantistico: nuove soluzioni pensate per - spiega Dell - consentire alle aziende di qualsiasi dimensione di accedere a "tecnologie una volta disponibili solo per i più grandi istituti di ricerca e agenzie governative".

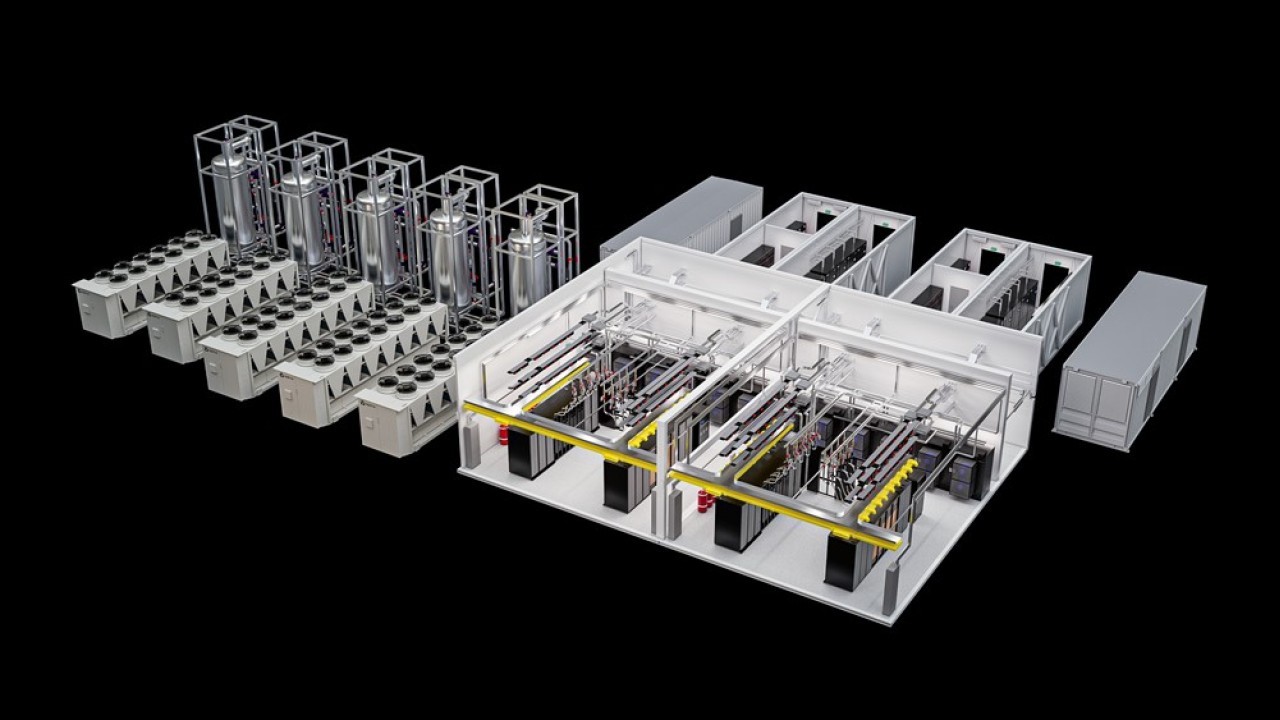

L'idea di un accesso "allargato" gioca decisamente sul ruolo di APEX come logica as-a-Service. La novità di spicco è infatti Dell APEX High Performance Computing, una verticalizzazione specifica dell'offerta APEX che comprende tutto ciò che serve per la gestione di workload HPC. È in sintesi una offerta di HPCaaS (HPC-as-a-Service) che toglie alle aziende il problema della creazione e della gestione di infrastrutture complesse come quelle a cluster che oggi muovono gli ambienti di elaborazione massiva.

Dell APEX High Performance Computing comprende una parte hardware basata su server Dell PowerEdge (Dell tra l'altro ne ha annunciati tre nuovi, i modelli XE9680, XE9640 e XE8640), acceleratori Nvidia e unità di storage dedicate, in configurazioni che partono da quasi duemila core e da 336 TB di storage. Lato software troviamo Red Hat Enterprise Linux come piattaforma operativa e Nvidia Bright Cluster Manager per la gestione dei cluster, più altri componenti per l'orchestrazione dei container e il job scheduling.

Al momento Dell propone soluzioni mirate per applicazioni in ambito Life Science, manufacturing e - annuncio recente - risk assessment finanziario. Queste soluzioni mirate sono, più tecnicamente, le Dell Validated Design Solutions. In sintesi, sono configurazioni ottimizzate per ambienti che devono essere, a seconda dei casi, più compute-intensive o più memory-intensive.

L'idea di fondo di "impacchettare" l'HPC in offerte APEX risponde a una duplice logica. Innanzitutto, le aziende sono molto interessate all'HPC as-a-Service perché ciò che vogliono è semplicemente (si fa per dire) eseguire applicazioni di nuova concezione per elaborare i propri dati, non certo assemblare e gestire cluster complessi. Questo è un compito gravoso che finirebbe per monopolizzare una parte importante dello staff IT. Per le aziende tecnologicamente più evolute magari è solo un male necessario, per molte altre diventa un ostacolo che fa dire addio all'HPC.

Il secondo aspetto da considerare è che le aziende oggi più interessate all'HPC vedono sì con favore l'as-a-Service, ma non in cloud. Il motivo è la tanto citata "data gravity": chi fa già HPC, o ci sta pensando, deve gestire enormi quantità di informazioni che è costoso spostare verso il cloud (ed eventualmente anche in senso opposto). Servono quindi offerte HPCaaS realizzabili on-premise, APEX è una di queste.

Non è una situazione transitoria in attesa di un inevitabile boom del cloud: l'HPC resterà un mercato essenzialmente on-premise per diversi anni ancora. Le stime di Hyperion Research indicano ad esempio che nel 2021 la quota cloud di questo mondo era inferiore al 15%, una percentuale che nel 2026 dovrebbe avvicinarsi al 23%. La crescita dell'HPC nella "nuvola" quindi sì, è rapida, ma oggi i fornitori tecnologici devono pensare soprattutto a un mercato che resta "dentro" i data center delle imprese.

L'opzione Quantum Computing

Se bisogna lavorare per rendere l'High Performance Computing "accessibile" alle imprese, figuriamoci il Quantum Computing. Sapendo poi che non avremo quantum computer "veri" prima di almeno cinque anni e che sino ad allora il potenziale del Quantum Computing non sarà veramente espresso. Oggi viviamo la fase di quelli che John Preskill del CalTech ha notoriamente battezzato Noisy Intermediate-Scale Quantum (NISQ) computer: hanno un numero troppo basso di qubit da superare definitivamente e in tutto i computer classici, sono incapaci di superare tale numero per problemi di interferenze che causano un elevato tasso di errori.

Questo vuol dire che non possiamo fare nulla con i computer quantistici attuali? Niente affatto, i NISQ sono un passo essenziale nello sviluppo del Quantum Computing. E ci sono operazioni in cui sono già nettamente superiori al computing tradizionale. Ma portarli nelle imprese - indirettamente come servizi cloud, raramente come sistemi fisici - è difficile.

La strada che molti indicano come preferenziale per i prossimi anni è il Quantum Computing ibrido, cioè una forma di elaborazione congiunta tra CPU e QPU (Quantum Processing Unit). In sintesi, il problema da risolvere viene scomposto in porzioni che si gestiscono meglio con le CPU/GPU e altre che è meglio dare in pasto a una QPU. L'equilibrio fra le due parti viene gestito automaticamente dal sistema ibrido stesso. Che in diversi casi ha dimostrato di funzionare meglio di un singolo sistema, tradizionale o anche quantistico.

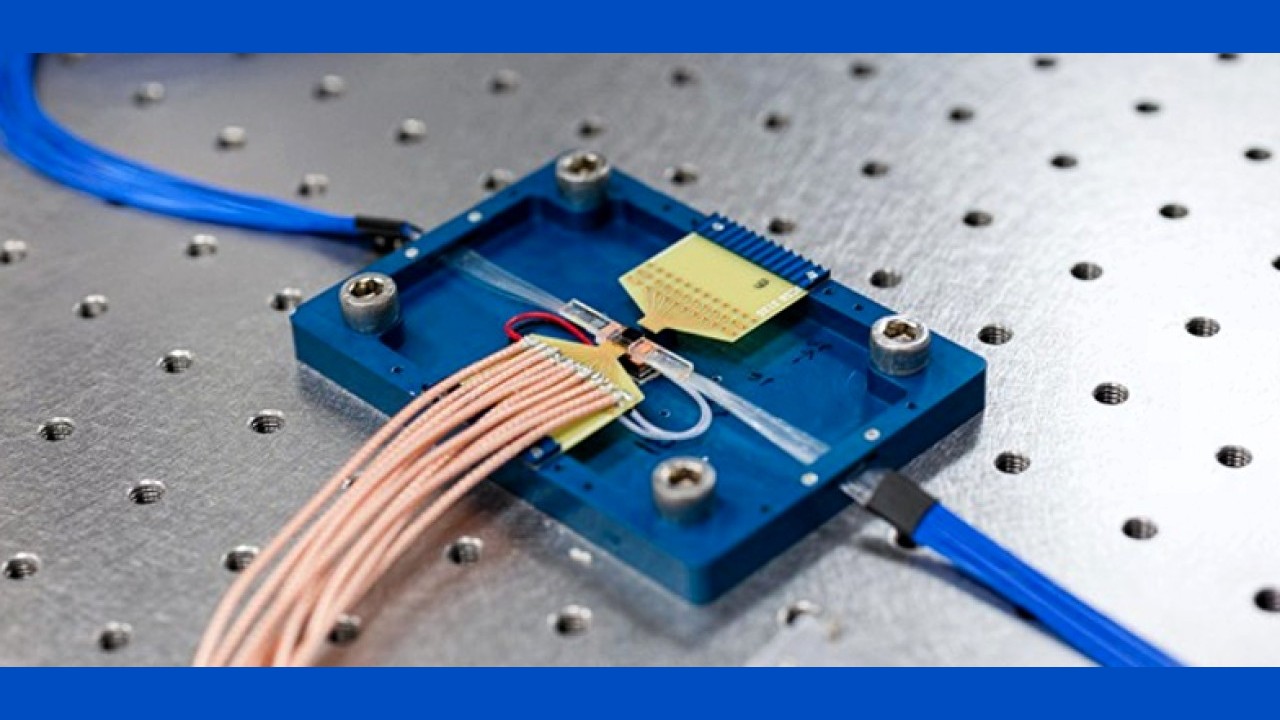

Dell ha scelto di "democratizzare" il Quantum Computing usando questo approccio, in collaborazione tecnologica con IonQ. Nella soluzione battezzata Dell Quantum Computing Solution, un cluster di server Dell PowerEdge con CPU e GPU tradizionali può eseguire elaborazioni classiche e anche quantistiche, mediante un simulatore di QPU. Il cluster è poi collegato a un servizio di Quantum Computing "vero" in cloud, basato su sistemi IonQ e quindi su QPU fisiche.

Come accennnato, nel sistema Dell i problemi da risolvere vengono scomposti in algoritmi per CPU e QPU. A suddividere questo carico in maniera ottimizzata è un modulo di orchestrazione, che attiva le QPU quando opportuno e, a seconda delle caratteristiche del problema, sceglie tra quelle virtuali in locale o quelle fisiche in remoto. Per problemi semplici che richiedono pochi qubit, infatti, una QPU virtuale può dare prestazioni migliori di una reale.

L'idea di Dell e IonQ è che un sistema ibrido semplifichi l'approccio delle aziende a un mondo che per loro è completamente nuovo. Gli sviluppatori possono iniziare a fare esperienza di un nuovo stile di sviluppo e analisi usando le QPU virtuali, passando poi a quelle reali quando c'è un vero vantaggio. Il sistema è inoltre scalabile orizzontalmente nella parte dei server PowerEdge, una scalabilità strutturale che non può ancora trovarsi nella parte quantistica.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Redazione ImpresaCity

Redazione ImpresaCity