Lenovo e Intel firmano il primo supercomputer raffreddato a liquido dell’Università di Harvard

Un’infrastruttura di HPC intelligente per la ricerca sulla previsione dei terremoti, della diffusione delle malattie e della formazione delle stelle

Il miglioramento delle previsioni delle scosse di assestamento dei terremoti attraverso il machine learning, la modellazione dei buchi neri attraverso i dati dei telescopi, la mappatura degli inquinanti invisibili dei mari, oppure lo sviluppo di una nuova analisi statistica per comprendere meglio i dettagli della formazione delle stelle. Sono solo alcune delle applicazioni del nuovo supercomputer realizzato da Lenovo in collaborazione con Intel, e destinato alla Facoltà di Arti e Scienze (FAS) Research Computing dell’Università di Harvard.

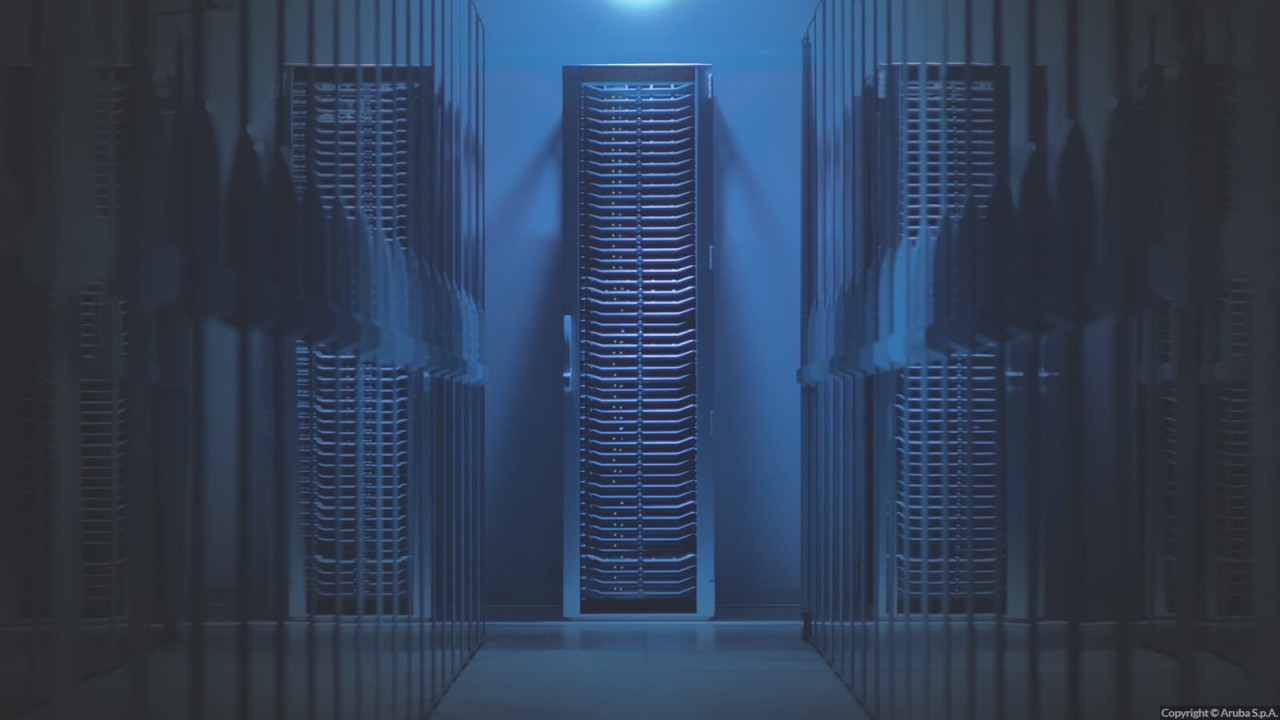

Intitolato Cannon in omaggio all’astronoma americana Anne Jump Cannon, il cluster è un sistema di High Performance Computing su larga scala che supporta attività di modellazione e simulazione per oltre 600 gruppi di laboratori e più di 4.500 ricercatori dei dipartimenti di scienze, ingegneria, scienze sociali, sanità pubblica e pedagogia di Harvard.

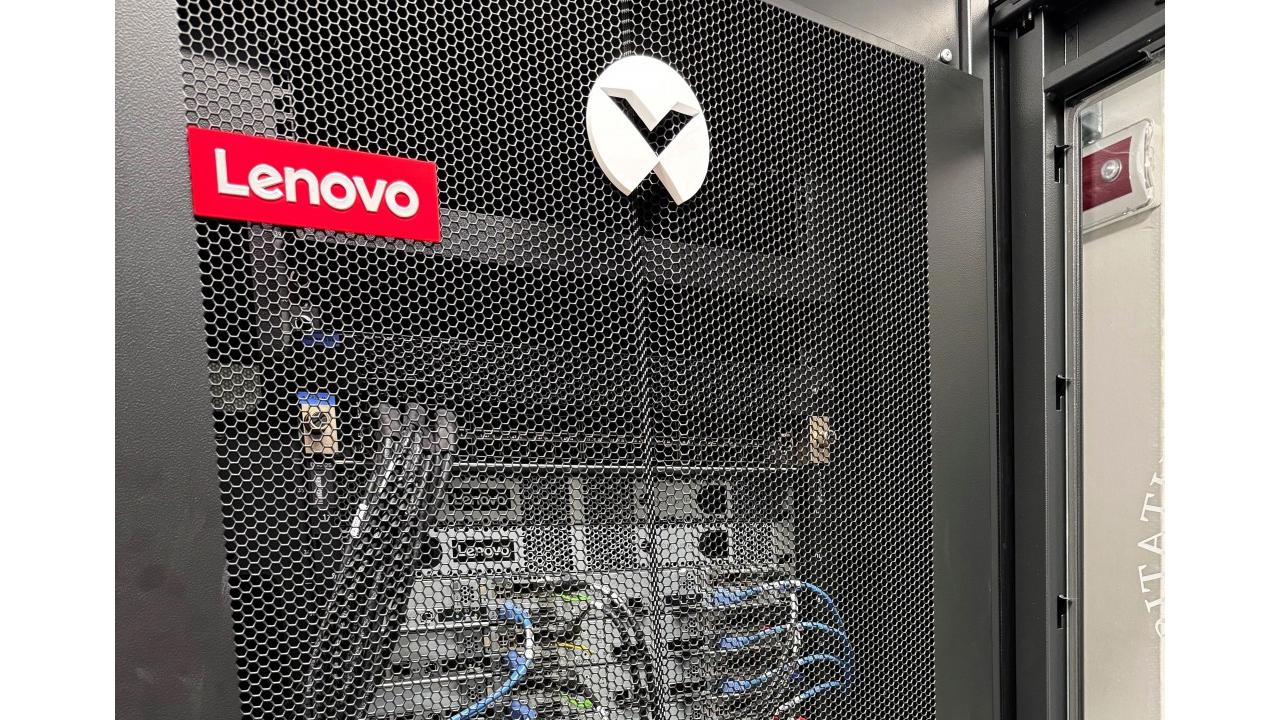

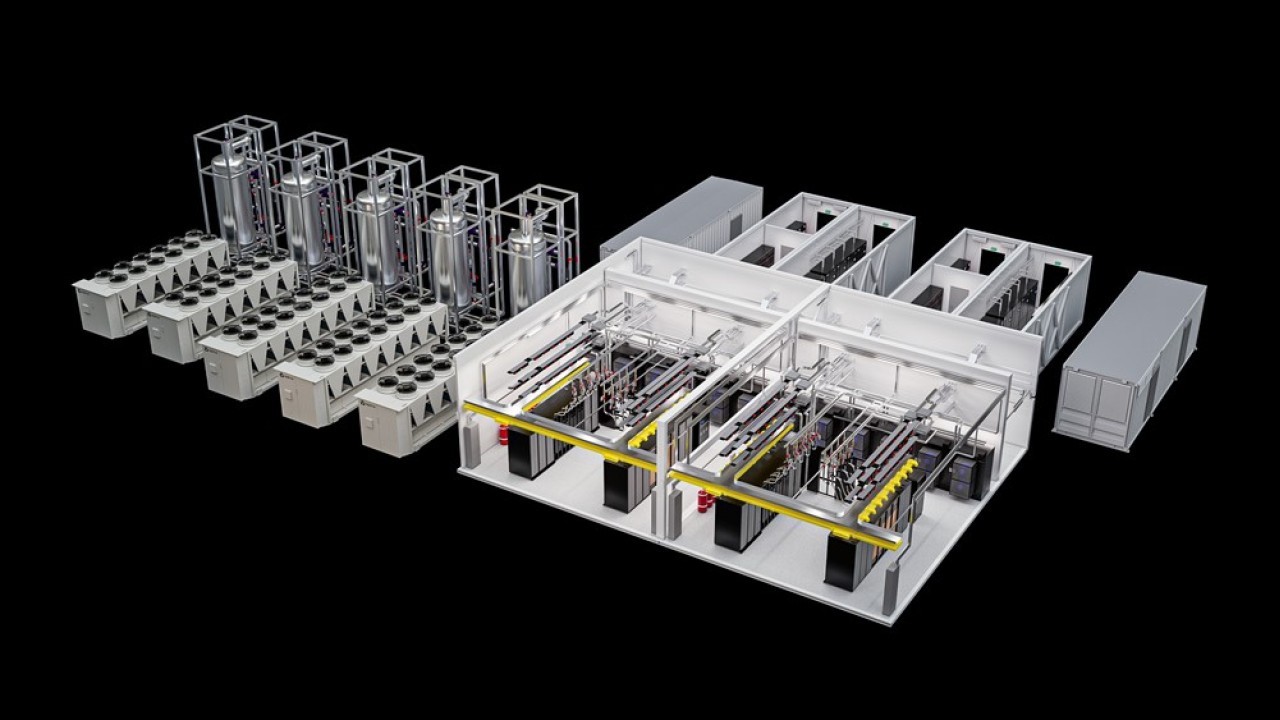

Composto da oltre 30.000 core di processori Intel Xeon scalabili di seconda generazione, Cannon include la tecnologia di raffreddamento a liquido Lenovo Neptune, che utilizza la superiore conducibilità termica dell’acqua rispetto all’aria per assicurare un migliore raffreddamento dei componenti e di conseguenza maggiori prestazioni e minori consumi energetici. Il centro di calcolo primario è installato presso il Massachusetts Green High Performance Computing Center: il cluster di Cannon comprende 670 server Lenovo ThinkSystem SD650 con raffreddamento ad acqua Neptune direct-to-node e processori Intel Xeon Platinum 8268 composti da 24 core per socket e 48 core per nodo. Nelle prime quattro settimane di operatività, Cannon ha eseguito più di 4,2 milioni di lavori utilizzando oltre 21 milioni di ore-CPU.

“La scienza si basa sull’iterazione e la ripetibilità, ma l’iterazione è un lusso che non è sempre disponibile nel campo della ricerca universitaria, perché molto spesso si lavora contro il tempo”, ha commentato Scott Yockel, director of research computing della facoltà di Arte e Scienze dell’Università di Harvard. “Con la maggiore capacità di calcolo e l’elaborazione più veloce del cluster Cannon, i nostri ricercatori hanno l’opportunità di effettuare molteplici tentativi nella loro sperimentazione. La possibilità di commettere errori e di imparare da essi consente ai nostri ricercatori di essere più competitivi”.

Intitolato Cannon in omaggio all’astronoma americana Anne Jump Cannon, il cluster è un sistema di High Performance Computing su larga scala che supporta attività di modellazione e simulazione per oltre 600 gruppi di laboratori e più di 4.500 ricercatori dei dipartimenti di scienze, ingegneria, scienze sociali, sanità pubblica e pedagogia di Harvard.

Composto da oltre 30.000 core di processori Intel Xeon scalabili di seconda generazione, Cannon include la tecnologia di raffreddamento a liquido Lenovo Neptune, che utilizza la superiore conducibilità termica dell’acqua rispetto all’aria per assicurare un migliore raffreddamento dei componenti e di conseguenza maggiori prestazioni e minori consumi energetici. Il centro di calcolo primario è installato presso il Massachusetts Green High Performance Computing Center: il cluster di Cannon comprende 670 server Lenovo ThinkSystem SD650 con raffreddamento ad acqua Neptune direct-to-node e processori Intel Xeon Platinum 8268 composti da 24 core per socket e 48 core per nodo. Nelle prime quattro settimane di operatività, Cannon ha eseguito più di 4,2 milioni di lavori utilizzando oltre 21 milioni di ore-CPU.

“La scienza si basa sull’iterazione e la ripetibilità, ma l’iterazione è un lusso che non è sempre disponibile nel campo della ricerca universitaria, perché molto spesso si lavora contro il tempo”, ha commentato Scott Yockel, director of research computing della facoltà di Arte e Scienze dell’Università di Harvard. “Con la maggiore capacità di calcolo e l’elaborazione più veloce del cluster Cannon, i nostri ricercatori hanno l’opportunità di effettuare molteplici tentativi nella loro sperimentazione. La possibilità di commettere errori e di imparare da essi consente ai nostri ricercatori di essere più competitivi”.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Abbonati alla rivista ImpresaCity Magazine e ricevi la tua copia.

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Feb 06

Il futuro della virtualizzazione: Red Hat OpenShift Virtualization

Feb 19

Commvault SHIFT 2026

Feb 26

Summit OVHcloud 2026 - Roma

Mar 05

Summit OVHcloud 2026 - Milano

Apr 17

Portare l’AI oltre la sperimentazione con OpenShift AI

Mag 26

CrowdTour 2026 - Milano

Giu 11

MSP DAY 2026

Redazione ImpresaCity

Redazione ImpresaCity