Autore: Edoardo Bellocchi

“L'intelligenza artificiale rappresenta un salto generazionale del modo in cui si usa il computing, ed è in grado di dare vita a una nuova era di espansione globale in cui l'informatica è ancora più fondamentale, la Siliconomy”. Non usa mezzi termini Pat Gelsinger, CEO di Intel, nel suo keynote all’evento Innovation 2023, l’annuale conferenza degli sviluppatori che si è svolta a metà settembre proprio dove Intel ha il proprio quartier generale, a San José in California, in quella Silicon Valley che intende continuare a essere al centro dell’IT, anche grazie ai nuovi sviluppi dati dalla convergenza tra Intelligenza artificiale, software e chip.

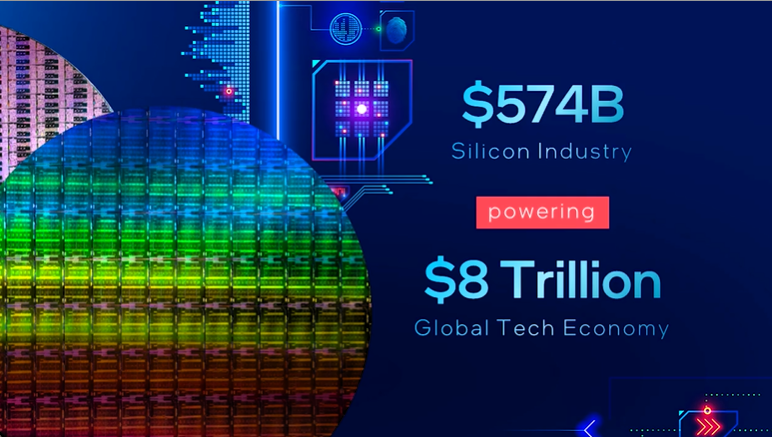

Perché, nelle parole di Pat Gelsinger, la Siliconomy nasce da questa convergenza, grazie all’AI che guiderà “un’economia in crescita abilitata dalla magia del silicio e del software: se oggi la fabbricazione dei chip alimenta un giro d’affari di 574 miliardi di dollari, che a sua volta alimenta un’economia tecnologica globale che vale quasi 8.000 miliardi di dollari, entro il 2030 questo valore praticamente raddoppierà, arrivando a un trilione di dollari, ovvero mille miliardi”, sulla spinta del costante diffondersi di dispositivi elettronici che sono sempre più pervasivi.

L’AI, quella generativa e non solo, entrerà sempre più in tutti i device, e questo, “per gli sviluppatori, crea enormi opportunità sociali e di business, nel ridefinire i confini del possibile”, ha proseguito Pat Gelsinger, introducendo come Intel stia portando le capacità di AI nei suoi prodotti hardware, rendendole accessibili attraverso soluzioni software open e multi-architettura, per portare l'intelligenza artificiale ovunque e in tutti i carichi di lavoro, dal client all'edge, dalla rete al cloud.

Ma l’Intelligenza Artificiale richiede come noto potenze di computing non indifferenti, oltre che programmi e software che la declinino in maniera accessibile a una platea sempre più vasta di utenti, ed è per questo che gli sviluppatori e i partner di Intel sono chiamati nel nuovo scenario a svolgere un ruolo rilevante. “L'AI del futuro deve offrire sempre più accesso, scalabilità, visibilità, trasparenza e fiducia all'intero ecosistema”, ha sottolineato Gelsinger nell’introdurre gli strumenti realizzati da Intel per aiutare gli sviluppatori a disegnare questo futuro.

Si comincia con la disponibilità generale di Intel Developer Cloud, che aiuta gli sviluppatori ad accelerare l'intelligenza artificiale utilizzando le più recenti innovazioni hardware e software di Intel, tra cui i processori Gaudi2 per il deep learning, e fornisce l'accesso alle più recenti piattaforme hardware di Intel, come i processori Xeon Scalable di quinta generazione e le GPU Data Center Max Series 1100 e 1550. Utilizzando Intel Developer Cloud, gli sviluppatori possono creare, testare e ottimizzare applicazioni AI e HPC.

Riguardo ai nuovi Gaudi2, Intel ha sottolineato che questi rappresentano “l'unica alternativa valida sul mercato per le esigenze di computing dell'AI”: non a caso, dal palco di San José, Pat Gelsinger ha anticipato che un supercomputer AI di grandi dimensioni sarà costruito interamente su processori Xeon e 4.000 acceleratori hardware Intel Gaudi2 AI, con Stability AI come cliente principale.

Tornando a Intel Developer Cloud, è stato evidenziato ch si basa su una base software aperta con oneAPI, ovvero un modello di programmazione aperto multi-architettura e multi-vendor, “per offrire una scelta hardware e la libertà da modelli di programmazione proprietari per supportare il calcolo accelerato e il riutilizzo e la portabilità del codice”: ogni riferimento a Nvidia è puramente casuale.

Ma il pezzo forte, sempre nella prospettiva di un’AI pervasiva basata sull’open source, è il toolkit OpenVINO, costituito da un framework che include modelli pre-addestrati ottimizzati per l'integrazione tra sistemi operativi e diverse soluzioni cloud, tra cui molti modelli di AI generativa, in modo da rendere più agevole l’utilizzo dell’AI all’interno dei programmi. Sul palco di Innovation 2023, aziende come ai.io e Fit:match hanno dimostrato come utilizzano OpenVINO per accelerare le loro applicazioni: ai.io per valutare le prestazioni di qualsiasi potenziale atleta, e Fit:match per rivoluzionare i settori retail e wellness, aiutando i consumatori a trovare gli indumenti più adatti.

Infine, è stato annunciato Project Strata, per lo sviluppo di una piattaforma software edge-native. La piattaforma verrà lanciata nel 2024 con blocchi modulari, servizi premium e offerte di supporto. Si tratta di un approccio orizzontale per scalare l'infrastruttura necessaria per l'intelligent edge e l'AI ibrida, e riunirà un ecosistema di applicazioni verticali di Intel e di terze parti. La soluzione consentirà agli sviluppatori di creare, distribuire, eseguire, gestire, connettere e proteggere l'infrastruttura e le applicazioni edge distribuite.

Non solo: Intel ha anche presentato in anteprima la nuova generazione di processori Xeon, rivelando che con la quinta generazione porteranno nei data center di tutto il mondo una combinazione di miglioramenti delle prestazioni e memoria più veloce, pur utilizzando la stessa quantità di energia, quando saranno lanciati il 14 dicembre. Grazie all’efficienza degli E-core, Sierra Forest, previsto per la prima metà del 2024, offrirà una densità di rack 2,5 volte superiore e prestazioni per Watt 2,4 volte più elevate rispetto allo Xeon di quarta generazione e includerà una versione con 288 core2. Granite Rapids, seguirà in tempi brevi il lancio di Sierra Forest e grazie ai P-core offrirà prestazioni dell’AI da 2 a 3 volte superiori rispetto agli Xeon2 di quarta generazione.

Infine, l’AI entra sempre più anche nei PC: “l'intelligenza artificiale trasformerà, rimodellerà e ristrutturerà radicalmente l'esperienza del PC, liberando la produttività e la creatività personali grazie alla potenza del cloud e dei PC che lavorano insieme”, ha spiegato Gelsinger, proclamando che “stiamo inaugurando la nuova era del PC AI”.

Nel dettaglio, gli sviluppi sono incentrati sui nuovi processori Intel Core Ultra, nome in codice Meteor Lake, dotati della prima unità di elaborazione neurale integrata di Intel, o NPU, per un'accelerazione dell'intelligenza artificiale e un'inferenza locale efficienti dal punto di vista energetico sul PC. Core Ultra, sul mercato dal 14 dicembre prossimo, rappresenta “un punto di svolta nella roadmap dei processori client di Intel”, sottolinea l’azienda, spiegando che “si tratta del primo progetto di chiplet client abilitato dalla tecnologia di packaging Foveros: oltre alla NPU e ai notevoli progressi in termini di efficienza energetica grazie alla tecnologia di processo Intel 4, il nuovo processore offre prestazioni grafiche di livello discreto grazie alla grafica Intel Arc integrata”.